请注意,本文编写于 973 天前,最后修改于 869 天前,其中某些信息可能已经过时。

改文章提到的包存在严重bug现已停用,请直接查看下面这篇部署即可:

注意:

1.不支持windows,不要用其他windows的包覆盖此包。

2.该包只加入了一些插件,其他与官方相同。

2.可以使用任意用户(包括root,但不推荐)运行。

3.该包使用Python3.10制作,实测只要系统中存在python>3.8以上即可跳过1~2步。

4.可以在autodl平台使用。

5.依赖包只包含cuda,需要amd rocm 看第8步。(没有amd显卡未测试)

Bugs:

1.已知插件dreambooth_extension会有一的概率在运行webui.sh卡者不动,解决方法:

rm -rf stable-diffusion-webui\extensions\dreambooth_extension

0.下载

https://www.123pan.com/s/S0HuVv-IfpOd 提取码:1111

阿里云盘:

https://www.aliyundrive.com/s/rWSMegad5px 提取码:k70w

注:阿里云盘需要将stable-diffusion-webui-l.txt 扩展名改为stable-diffusion-webui-l.zip

1.部署conda环境 (如果有python或conda就跳过)

先上传Miniconda3-latest-Linux-x86_64.sh 到服务器

bash ./Miniconda3-latest-Linux-x86_64.sh -b -f

打开.bashrc:

cd ~

vi .bashrc

添加环境变量,将光标放在最后一行({username}根据自己的电脑的用户名进行修改):

export PATH=$PATH:/home/{username}/miniconda3/bin

然后执行:

source .bashrc

继续执行:

conda init

bash

执行后终端前面如下显示即为成功

(base) usr@server:~$

2.使用conda部署Python3.10环境(已有python环境可以跳过)

conda create -n py310 python=3.10

conda activate py310

执行后终端前面如下显示即为成功

(py310) usr@server:~$

3.解压

unzip -q stable-diffusion-webui-l.zip

4.修改stable-diffusion-webui/venv/lib64文件夹

(必须修改,不修改会重新下载所有依赖文件)

cd stable-diffusion-webui/venv/

ln -s lib lib64

5.放入模型ckpt文件

mv {你的模型文件名.ckpt} stable-diffusion-webui/models/Stable-diffusion/

mv {你的模型文件名.vae.ckpt} stable-diffusion-webui/models/VAE/

6.编辑webui-user.sh

vi webui-user.sh

将需要的命令放到这里,就像下面这样:

export COMMANDLINE_ARGS="--你的命令"

例如:

export COMMANDLINE_ARGS="--skip-torch-cuda-test --deepdanbooru"

退出

7.运行webui.sh

bash webui.sh

可以愉快的炼丹了

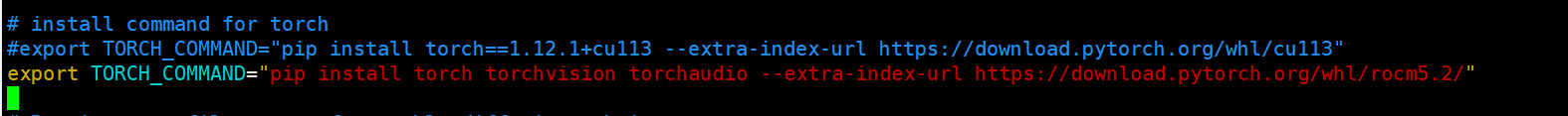

8.添加amd显卡 rocm5.2(未测试)(amd显卡)

编辑webui-user.sh

修改export TORCH_COMMAND,就像下面这样:

export TORCH_COMMAND="pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/rocm5.2/"

然后按第7步运行,将自动安装依赖(可能需要代理)

更新webui

理论上每次运行webui.sh时会自动更新,但任然可以手动运行:

在stable-diffusion-webui文件夹下执行:

git pull

有问题可以下方留言

7 comments

失效了

Bug提醒:

刚查明一个bug,自带的venv有一定几率activate不上,会出现重新下载依赖包到系统中的bug,通过查阅资料发现venv虚拟环境不能直接移植的问题。所以将在近期发一篇文章,直接看那个文章就行,不要看这个了

新文章链接:https://www.ymhworld.cn/archives/36/

我看依赖里面已经有Torch,为什么运行webui.sh还需要下载

刚查明这是一个bug,自带的venv有一定几率activate不上

1.deepin20.7可以部署不

2.按照voldy版本进行部署,运行sh文件时,下载依赖Torch一段时间后,终端闪退;或者使用打包好的一键部署,运行sh文件终端会直接闪退。deepin自带的Python是3.7.3,是不是版本低了

deepin20.7是可以部署的,Python是3.7.3版本有点低了,按文中第一步部署一个python3.10版本的试一试